- A+

机器之心PRO · 会员通讯 Week 34

---- 本周为您解读 ③个值得细品的 AI & Robotics 业内要事 ----

1. 模型成本疾速上升/下降,哪些技术让训 AI 更省钱?

模型训练成本是激增还是骤降?两种说法分别是什么依据?降低训练成本有哪些手段?最近都有谁用低成本训除了更好的模型?...

2. 如何从零开始深入大热赛道:人形机器人技术全梳理

最近新发布的人形机器人都有哪些特点?为什么说人形机器人是 AI 的终极应用形态?人形机器人赛道的整体情况如何?为什么人形机器人还「不好用」?有哪些行业共性难点?人形机器人背后的底层技术/原理是什么?人形机器人赛道面临着哪些关键难题?...

3. 调研近 400 篇文献,综述全面解析具身智能

具身智能发展到什么程度了?具身智能体的常见载体和仿真工具有哪些?具身感知都有哪些做法?具身交互数据仍旧匮乏吗?具身智能体能做好规划和控了吗?实现 Sim2Real 还差多远?...

...本期完整版通讯含 3 项专题解读 + 27 项本周 AI & Robotics 赛道要事速递,其中技术方面 10 项,国内方面 9 项,国外方面 8 项。

本期通讯总计 30648 字,可免费试读至 12%

消耗 99 微信豆即可兑换完整本期解读(约合人民币 9.9 元)

要事解读① 模型成本疾速上升/下降,哪些技术让训 AI 更省钱?

日期:8 月 10 日

事件:有关大模型公司收支鸿沟的讨论在近期越来越来越频繁。Anthropic 公司联合创始人兼首席执行官 Dario Amodei 近期在访谈中预测大模型的训练成本将急剧上涨,但方舟投资却在一份报告中指出大模型的训练和推理成本均在大幅下降,与大多数声音「背道而驰」。

大模型的训练成本到底是在激增还是骤降?

以斯坦福《AI Index 2024》报告和 Dario Amodei 均指出大模型的训练成本正在急剧上升,但方舟投资(Ark Invest)的报告确指出大模型的训练和推理成本均在下降,吴恩达在近期与方舟投资的对谈中同样认可了这一趋势观察。虽然两种声音对大模型训练成本的看法截然相反,但从两者的出发点来看似乎并不冲突。

1、OpenAI 前研究副总裁、Anthropic 公司联合创始人兼首席执行官 Dario Amodei 在自今年以来多次于访谈中分享了对人工智能以及大模型技术未来趋势的看法,并强调大模型的训练成本将持续上升。

① Dario Amodei 在 4 月与《纽约时报》的访谈中表示,在不久的将来,大语言模型的训练成本将从现在的 1 亿美元上升至 10 亿美元左右。[13]

② 而后在 7 月与 In Good Company 的播客节目中,Dario Amodei 对训练成本的涨幅预测进一步上升,他表示从现在开始的三年内,AI 模型的训练成本将上升到 100 亿美元甚至 1000 亿美元。[15]

③ Amodei 表示,AGI 不会在某个节点突然实现。相反,这将是一个循序渐进的过程。如果 AI 模型每年的性能提高十倍,我们可以合理地预测它们所需的硬件的性能也会至少提高十倍,因而硬件可能是 AI 训练中最大的成本驱动因素。

2、斯坦福在《AI Index 2024》报告中同样指出 AI 模型的训练成本正在飞速增长,在短短几年中从千余美元上涨至以亿美元为单位计算。[14]

① 根据《AI Index 2024》的强调了模型参数和训练成本的关系,模型参数越大,其训练所需的算力和能耗越高。

② 报告指出,2017 年训练初版 Transformer 的成本仅消耗 900 美元左右,但 2019 年训练 RoBERTa Large 的成本已升至约 160000 美元,而 2023 年 OpenAI 训练 GPT-4 的成本为 7800 万美元(后被 Altman 证明是 1 亿),谷歌训练 Gemini Ultra 则需消耗约 1.91 亿美元。

3、另一方面,方舟投资在《Big Idea 2024》年度报告中指出,从 Traning Performance 来看,在接下来的三年中,大模型的训练成本每年下降 75%,推理成本每年下降 86%。[17]

① 吴恩达近日于方舟投资的对谈中则指出,虽然并不确定报告中的数据是否准确,但打确实看到了成本在迅速下降。而训练和推理成本的下降将会推动更多的应用,对进一步创新非常有利。[16]

上升 or 下降,大模型训练成本如何计算?

对于大模型的训练成本中的开销构成,业界已经陆续有过很多分析。对比以 Dario Amodei 为代表的训练成本激增的判断,以及方舟投资对训练成本下降趋势的观察,两者的主要区别在于前者讨论从零开始组建团队训练最强的大模型,后者则参考 Wright’s Law,将固定成本在复用中分摊和因算法改进而提升训练效果的「性价比」纳入了考量范围。

1、根据 Dario Amodei 在访谈中的描述,以及业界的补充分析,AI 模型的训练成本主要来自「硬件采购」「能源消耗」「人才」和「数据」几方面。[19] [20] [21]

① 硬件成本(或算力成本)是公认支出大头。随着 AI 模型的规模扩大,训练所需的硬件(如 GPU、TPU、CPU 集群等)需求也在不断增加。

② 能源消耗在模型训练成本中占据较高比例。训练是一个高度能源密集的过程,数据中心的电力消耗、冷却设施运行以及潜在的碳排放成本构成了能源成本。

③ 训练 AI 模型的一部分成本来自人才。公司需要一支专业的工程师和科学家团队,包括数据工程师、AI 研究员、软件工程师等。为了吸引和保留这些人才,公司需要支付高额的薪资和福利。

④ 数据成本同样是模型训练的重要考量,高质量、大规模的训练数据对于 AI 模型的性能至关重要。数据采集、标注、清洗、存储和传输等环节会产生相应的成本。

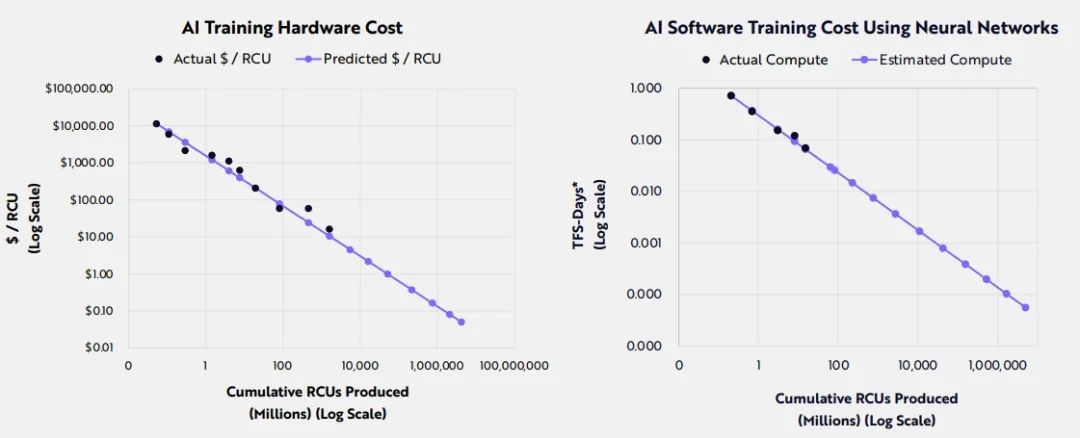

2、方舟投资在《Big Idea 2024》年度报告中通过 Wright's Law 来估算 AI 训练成本,发现加速计算硬件硬件的改进应当会使 AI 相关计算单元(RCU)的生产成本每年降低 53%,而算法模型的增强可能会进一步使训练成本每年降低 47%。换句话说,硬件和软件的融合可能会推动 AI 训练成本以每年 75%的速率下降,直到 2030 年。

① Wright's Law 是一个经验法则,其核心观点是,当生产某一产品的数量增加时,生产过程中的固定成本(如研发、设备投资)可以分摊到更多的单位产品上,导致单位产品的平均成本下降。

② 在模型训练成本的背景下,Wright's Law 同样适用。随着 AI 模型训练的数量增加,相关的固定成本(如硬件投资、数据收集和标注成本)可以在更多的模型或模型迭代上分摊。

③ 随着技术的进步和规模化生产,用于训练 AI 模型的硬件和软件也可能变得更加高效和经济。由此,随着时间的推移和训练数量的增加,单位模型的训练成本可能会下降。

3、在前一年的报告(《Big Idea 2023》)中,方舟投资对 AI 训练成本的估算为每年以 70%的速度下降。以将一个 LLM 训练到 GPT-3 水平为例,其成本从 2020 年的 460 万美元在 2022 年下降至 45 万美元(将至 10%)。[18]

③ 根据报告研究组的建模,训练一个比 GPT-3 多 57 倍参数和 720 倍语言符号的 AI 模型的成本,将从 2022 年的 170 亿美元下降到 2030 年的 60 万美元。

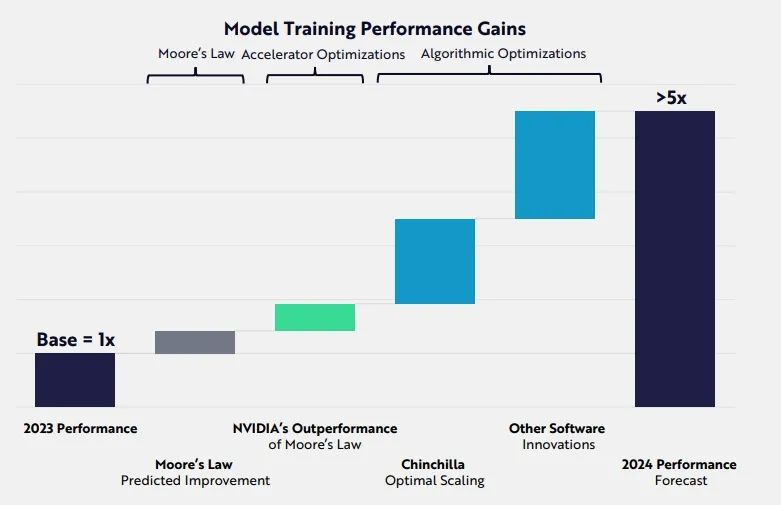

4、《Big Idea 2024》的另一个观察是,研究人员通过在训练和推理、硬件以及模型设计上的创新带来了模型训练的提升和成本的降低。

① 这部分从硬件和软件的角度估算了技术创新让模型对模型训练效果的帮助。相比硬件,报告认为算法和软件层面的进会为模型训练带来更高的性价比,在实现同样性能的前提下成本更低。

5、吴恩达在访谈中认可了 Ark Invest 对趋势的判断,并补充表示开源的预训练模型同样也是新团队节约了大量的成本,而开发更好的流程(agentic workflow)可让预训练模型表现更好,不用从头训练。

① 吴恩达还在访谈中提到,有关 AI 模型的训练和推理在未来将会可能变成两套设施。当前有很多公司因为设施在训练上有效果而惯性地将其用作推理,但推理和训练的设施是否存在足够差异,甚至需要新的架构仍是值得讨论的问题。

降低训练成本的手段有哪些?

由于硬件的迭代和算力的价格并非模型开发者能够掌控,许多团队会选择采用开源预训练模型进行微调+RAG,或是基于大尺寸的模型蒸馏出参数规模更小的模型,避免从头训练的成本。Meta 此前在发布 Llama 3.1 405B 时同样强调了他们对开源的努力。另一方面,也有很多团队通过算法或是数据工作上的创新来提高模型表现,同时节约成本。

1、Semianalysis 在 2023 年初的一篇文章中分析了头部厂商在 AI 模型训练上的成本,并介绍了用于改善大模型的训练和推理成本/效率的技术与策略,分别是稀疏性(sparsity)、剪枝(pruning)、专家混合(MoE)以及提 early exit/token dropping/token merging。[20]

① 该文章的分析逻辑仅关注硬件成本,通过参数数量、token 数量和模型架构计算了许多流行模型的理论训练成本,并强调即便采用 Nvidia A100 GPU,其模型/硬件的 FLOPS 利用率的商业也只有 60%

② 在此基础上,该文章介绍的四种技术从不同层面提高了 FLOPS 利用率。

2、稀疏性(Sparsity)指在模型训练过程中,许多权重参数实际上为零。这种现象在大型模型训练初期尤为常见。

① 由于任何数乘以 0 都是 0,这些零权重实际上是无效的计算操作,但它们仍然消耗计算资源。

② 通过利用稀疏性,可以跳过这些无效的计算,从而减少计算量,提高训练效率,并降低能耗。

③ 论文《Large Models are Parsimonious Learners: Activation Sparsity in Trained Transformers》探讨了大型 Transformer 模型在训练过程中的激活稀疏性,并展示了如何利用这种稀疏性来提高效率。